SG.hu

Nem biztos, hogy baj, hogy a mesterséges intelligencia hallucinál

Nagy probléma, ha a chatbotok valótlanságokat terjesztenek, de bosszankodás helyett talán ünnepelnünk kellene ezeket a hallucinációkat, mint az emberi kreativitás ösztönzőit és a gépek hatalomátvételének akadályát.

Senki sem tudja, hogy a mesterséges intelligencia áldás vagy átok lesz-e a távoli jövőben, de jelenleg szinte általános megvetés övezi ezeknek a chatbotoknak egy szokását: a hallucinációkat, miszerint kitalált tények jelennek meg az olyan nagy nyelvi modellek kimeneteiben, mint a ChatGPT. Egy gondosan felépített válasz közepén becsúszik valami olyan, ami ésszerűnek tűnik, de teljesen kitalált. Mivel elkerülhetetlennek tűnik, hogy egy napon chatbotok fogják generálni a valaha írt prózai szövegek túlnyomó többségét, az összes MI-cég megszállottan azon van, hogy minimalizálja és kiküszöbölje ezeket a hallucinációkat, vagy legalábbis meggyőzze a világot arról, hogy a probléma kézben tartható. Nyilvánvaló, hogy az LLM-ek értéke új szintet ér el, amikor és amennyiben a hallucinációk megközelítik a nullát. De addig is próbáljunk meg örülni a létezésüknek.

A mesterséges intelligencia tudósainak elég jó elképzelésük van arról, hogy ilyenek miért történnek. Egy Vectara nevű MI startup tanulmányozta őket és elterjedtségüket, sőt, még a különböző modellek hallucinációs arányát is összeállította. (A legjobban az OpenAI GPT-4 teljesít, amely az esetek mindössze 3 százalékában hallucinál; a Google mára már elavult Palm Chat-je - nem a chatbotja, a Bard - 27 százalékos arányt ért el). Amin Ahmad, a Vectara műszaki igazgatója szerint az LLM-ek a betáplált összes képzési adat tömörített reprezentációját hozzák létre. "A tömörítés természetéből adódóan a finom részletek elveszhetnek" - mondja. A modell végül a felhasználók lekérdezéseire adott legvalószínűbb válaszokkal alapozódik meg, de nem rendelkezik a pontos tényekkel. "Amikor a részletekhez ér, elkezd dolgokat kitalálni" - mondja.

Santosh Vempala, a Georgia Tech informatika professzora szintén tanulmányozta a hallucinációkat. "A nyelvi modell csak a világ valószínűségi modellje" - mondja -, nem pedig a valóság hű tükre. Egy LLM válasza általános egyezésre törekszik a valós világgal - ahogy azt a képzési adatai reprezentálják -, ami "a pontosság gyenge változata". Kutatása szerint a hallucinációk elkerülhetetlenek az olyan tények esetében, amelyek nem ellenőrizhetők a modell képzési adataiban szereplő információk segítségével.

Ez a tudomány/matematika a dolog mögött, de ezek a hallucinációk az emberekben kiváltható élmény miatt is figyelemre méltóak. Időnként ezek a generatív kitalációk hihetőbbnek tűnhetnek, mint a tényleges tények, amelyek gyakran megdöbbentően bizarrak. Hányszor írnak a bulvárlapok olyan dolgokról, amit még forgatókönyvírók sem mernének beleírni a filmekbe? A hallucinációk azzal csábíthatnak el minket, hogy egy olyan világhoz kötnek minket, amely kevésbé megrázó, mint az amelyben valójában élünk. Sokatmondó, hogy milyen részleteket szoktak a botok kitalálni. Kétségbeesett kísérletükben, hogy kitöltsék a kielégítő narratíva hiányosságait, a valóság statisztikailag legvalószínűbb verziójához húznak.

Mivel az LLM-ek nem feltétlenül úgy gondolkodnak, mint az emberek, a statisztikai fantázia szárnyalása értékes eszköz lehet a kreativitás ösztönzésére. "A generatív rendszereket egyre inkább a művészek fedezik fel, hogy olyan ötleteket kapjanak, amelyekre nem feltétlenül gondoltak volna" - mondja Ahmad, a Vectara munkatársa. A mesterséges intelligenciát fejlesztők egyik legfontosabb küldetése, hogy segítsenek megoldani az emberiség megoldhatatlan problémáit, olyan ötletekkel, amelyek túlmutatnak az emberi képzelet határain. Ahmad egyike azoknak, akik úgy vélik, hogy még ha ki is találjuk, hogyan lehet nagyrészt kiküszöbölni ezeket az algoritmikus füllentéseket, akkor is meg kell tartanunk őket. "Az LLM-eknek képesnek kell lenniük arra, hogy hallucinációk nélkül is produkáljanak dolgokat, de át kell tudjuk fordítani őket egy olyan üzemmódba, ahol hallucinációkat tudnak produkálni, és segítenek nekünk az ötletelésben" - mondja. Vempala a Georgia Tech-től egyetért: "Amikor vezetni akarod az autódat, nem akarod, hogy a mesterséges intelligencia kitalálja, hogy mi van az úton, de akkor igen, amikor verset akarsz írni valakinek".

Jelenleg ez a pontatlanság ad némi lélegzetvételnyi teret az emberiségnek a szuperintelligens mesterséges intelligencia entitásokkal való együttélésre való áttérésben. Mivel nem bízhatunk abban, hogy az LLM-ek válaszai helyesek, még mindig el kell végeznünk a tényellenőrzésüket. Vegyük példának a jogi szakmát. Még ha a LLM-ek képesek is hitelesnek tűnő jogi dokumentumokat készíteni, az eredmény katasztrofálisan kitalált lehet. Ez előfordult már egy híres esetben, amikor két ügyvéd hat olyan bírósági véleményre hivatkozva nyújtott be egy keresetet, amelyekről kiderült, hogy teljes egészében a ChatGPT találta ki azokat. A bíró szankcionálta az ügyvédeket, ők pedig nevetség tárgyává váltak. Ezt követően csak egy teljesen idióta jogász használna chatbotokat arra, hogy előássa az érvelést alátámasztó esetjogot, és ne ellenőrizze kétszeresen az eredményt.

Az ügyvédeknek maguknak kell felszínre hozniuk a korábbi eseteket, és ez egy jó dolog. Képzeljük el, ha a mesterséges intelligencia képes lenne megbízhatóan létrehozni egy meggyőző jogi beadványt, és teljes pontossággal hajtana végre mindent. Az ügyvédek ezeket anélkül nyújtanák be, hogy megnéznék őket, biztosak lennének abban, hogy relevánsak. Ezek után a bírókon múlik majd, hogy mérlegeljék, hogyan alkalmazhatók ezek az esetek. Természetesen a mesterséges intelligenciához fognak fordulni, hogy összefoglalják a tényállást, és talán még a végső véleményük megfogalmazásához is mesterséges intelligenciát használnak majd. Végül az egész ítélkezési gyakorlatunkat az MI által indított és elbírált érvek fogják meghatározni. Az emberek csak nézők lesznek, a jogi szakembereknek pedig nagyon kevés munkájuk lesz.

Ugyanez vonatkozik más, pontosságot igénylő területekre is, ami nagyjából minden emberi szakmát jelent. Mivel nem bízhatunk az LLM-ekben, a hallucinációk egyfajta tűzfalat jelentenek köztünk és a tömeges munkanélküliség között. Eljön-e valaha az a nap, amikor megszabadulunk a hallucinációktól? A tudósok nem értenek egyet. "A válasz tág értelemben véve nem" - mondja Vempala, Ahmad viszont úgy gondolja, hogy megtehetjük. "A kutatóközösségben mostanában nagy figyelem irányul a hallucináció problémájára, és mindenféle szempontból foglalkoznak vele" - mondja.

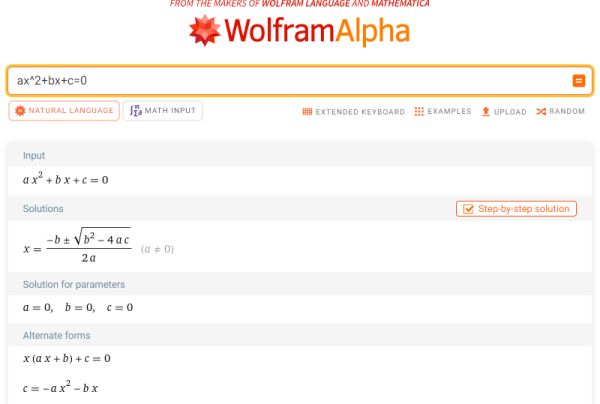

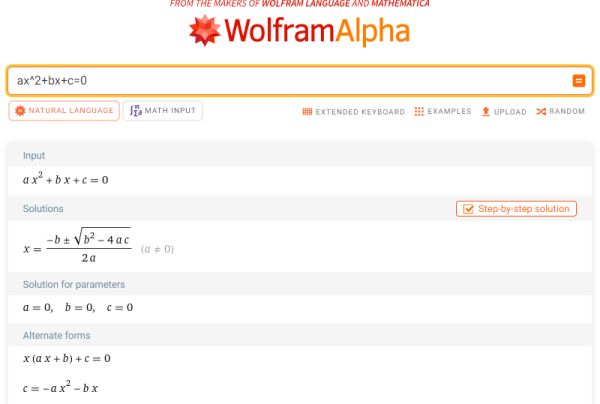

Állandó táncot járunk a gépekkel, egyre inkább függő ölelésbe zárva. És mégis, mivel a robotok viselkedése nem emberi gondolkodási folyamatokon alapul, gyakran tehetetlenek vagyunk, hogy megmagyarázzuk tetteiket. A Stephen Wolfram által létrehozott Wolfram Alpha weboldal számos matematikai problémát képes megoldani. Úgy tűnik, azt is megjeleníti, hogy ezek a válaszok hogyan jönnek létre. Az emberek által látott logikai lépések azonban teljesen eltérnek a weboldal tényleges számításaitól. "Nem végez semmilyen érvelést" - mondja Wolfram. "Azok a lépések tiszta hamisítványok. De hogyan magyarázzuk el ezt egy embernek?"

A számítógépeknek néha csalniuk kell, különben kényelmetlenséget okoznak. Eric Horvitz - ma a Microsoft egyik vezető kutatója - az 1980-as években segített egy mesterséges intelligencia rendszert létrehozni, amely a patológusokat segítette a vizsgálatokban. Minden egyes eredményt elemzett, és javaslatot tett a következő vizsgálat elvégzésére. Egyetlen probléma volt csak - túl gyorsan adta meg a válaszokat. "Úgy találtuk, hogy az emberek jobban bíztak benne, ha egy villogó fénnyel ellátott késleltetési hurkot adtunk hozzá, mintha a rendszer a gombnyomás után azonnal előállt volna a válasszal" - mondja Horvitz.

De meg kell tanulnunk alkalmazkodni. A mesterséges intelligencia olyannyira létfontosságú egyes rendszerek - például a pénzügyi infrastruktúra - számára, hogy megszabadulni tőle sokkal nehezebb lenne, mint leválasztani a HAL 9000 moduljait. "Bizonyos értelemben azt mondhatjuk, hogy a sci-fi forgatókönyvek már most kezdenek megvalósulni" - mondja Hillis, a Thinking Machines munkatársa. "A számítógépek irányítanak, mi pedig az ő világukban élünk". Wolfram szerint ez a rejtély fokozódni fog, ahogy a mesterséges intelligencia új feladatokat vesz át, és egyre inkább kikerül az emberi felfogóképesség köréből. "Szabályozzuk-e a mögöttes algoritmust?" - kérdezi. "Ez őrültség, mert a legtöbb esetben nem lehet előre látni, hogy egy algoritmusnak milyen következményei lesznek."

Senki sem tudja, hogy a mesterséges intelligencia áldás vagy átok lesz-e a távoli jövőben, de jelenleg szinte általános megvetés övezi ezeknek a chatbotoknak egy szokását: a hallucinációkat, miszerint kitalált tények jelennek meg az olyan nagy nyelvi modellek kimeneteiben, mint a ChatGPT. Egy gondosan felépített válasz közepén becsúszik valami olyan, ami ésszerűnek tűnik, de teljesen kitalált. Mivel elkerülhetetlennek tűnik, hogy egy napon chatbotok fogják generálni a valaha írt prózai szövegek túlnyomó többségét, az összes MI-cég megszállottan azon van, hogy minimalizálja és kiküszöbölje ezeket a hallucinációkat, vagy legalábbis meggyőzze a világot arról, hogy a probléma kézben tartható. Nyilvánvaló, hogy az LLM-ek értéke új szintet ér el, amikor és amennyiben a hallucinációk megközelítik a nullát. De addig is próbáljunk meg örülni a létezésüknek.

A mesterséges intelligencia tudósainak elég jó elképzelésük van arról, hogy ilyenek miért történnek. Egy Vectara nevű MI startup tanulmányozta őket és elterjedtségüket, sőt, még a különböző modellek hallucinációs arányát is összeállította. (A legjobban az OpenAI GPT-4 teljesít, amely az esetek mindössze 3 százalékában hallucinál; a Google mára már elavult Palm Chat-je - nem a chatbotja, a Bard - 27 százalékos arányt ért el). Amin Ahmad, a Vectara műszaki igazgatója szerint az LLM-ek a betáplált összes képzési adat tömörített reprezentációját hozzák létre. "A tömörítés természetéből adódóan a finom részletek elveszhetnek" - mondja. A modell végül a felhasználók lekérdezéseire adott legvalószínűbb válaszokkal alapozódik meg, de nem rendelkezik a pontos tényekkel. "Amikor a részletekhez ér, elkezd dolgokat kitalálni" - mondja.

Santosh Vempala, a Georgia Tech informatika professzora szintén tanulmányozta a hallucinációkat. "A nyelvi modell csak a világ valószínűségi modellje" - mondja -, nem pedig a valóság hű tükre. Egy LLM válasza általános egyezésre törekszik a valós világgal - ahogy azt a képzési adatai reprezentálják -, ami "a pontosság gyenge változata". Kutatása szerint a hallucinációk elkerülhetetlenek az olyan tények esetében, amelyek nem ellenőrizhetők a modell képzési adataiban szereplő információk segítségével.

Ez a tudomány/matematika a dolog mögött, de ezek a hallucinációk az emberekben kiváltható élmény miatt is figyelemre méltóak. Időnként ezek a generatív kitalációk hihetőbbnek tűnhetnek, mint a tényleges tények, amelyek gyakran megdöbbentően bizarrak. Hányszor írnak a bulvárlapok olyan dolgokról, amit még forgatókönyvírók sem mernének beleírni a filmekbe? A hallucinációk azzal csábíthatnak el minket, hogy egy olyan világhoz kötnek minket, amely kevésbé megrázó, mint az amelyben valójában élünk. Sokatmondó, hogy milyen részleteket szoktak a botok kitalálni. Kétségbeesett kísérletükben, hogy kitöltsék a kielégítő narratíva hiányosságait, a valóság statisztikailag legvalószínűbb verziójához húznak.

Mivel az LLM-ek nem feltétlenül úgy gondolkodnak, mint az emberek, a statisztikai fantázia szárnyalása értékes eszköz lehet a kreativitás ösztönzésére. "A generatív rendszereket egyre inkább a művészek fedezik fel, hogy olyan ötleteket kapjanak, amelyekre nem feltétlenül gondoltak volna" - mondja Ahmad, a Vectara munkatársa. A mesterséges intelligenciát fejlesztők egyik legfontosabb küldetése, hogy segítsenek megoldani az emberiség megoldhatatlan problémáit, olyan ötletekkel, amelyek túlmutatnak az emberi képzelet határain. Ahmad egyike azoknak, akik úgy vélik, hogy még ha ki is találjuk, hogyan lehet nagyrészt kiküszöbölni ezeket az algoritmikus füllentéseket, akkor is meg kell tartanunk őket. "Az LLM-eknek képesnek kell lenniük arra, hogy hallucinációk nélkül is produkáljanak dolgokat, de át kell tudjuk fordítani őket egy olyan üzemmódba, ahol hallucinációkat tudnak produkálni, és segítenek nekünk az ötletelésben" - mondja. Vempala a Georgia Tech-től egyetért: "Amikor vezetni akarod az autódat, nem akarod, hogy a mesterséges intelligencia kitalálja, hogy mi van az úton, de akkor igen, amikor verset akarsz írni valakinek".

Jelenleg ez a pontatlanság ad némi lélegzetvételnyi teret az emberiségnek a szuperintelligens mesterséges intelligencia entitásokkal való együttélésre való áttérésben. Mivel nem bízhatunk abban, hogy az LLM-ek válaszai helyesek, még mindig el kell végeznünk a tényellenőrzésüket. Vegyük példának a jogi szakmát. Még ha a LLM-ek képesek is hitelesnek tűnő jogi dokumentumokat készíteni, az eredmény katasztrofálisan kitalált lehet. Ez előfordult már egy híres esetben, amikor két ügyvéd hat olyan bírósági véleményre hivatkozva nyújtott be egy keresetet, amelyekről kiderült, hogy teljes egészében a ChatGPT találta ki azokat. A bíró szankcionálta az ügyvédeket, ők pedig nevetség tárgyává váltak. Ezt követően csak egy teljesen idióta jogász használna chatbotokat arra, hogy előássa az érvelést alátámasztó esetjogot, és ne ellenőrizze kétszeresen az eredményt.

Az ügyvédeknek maguknak kell felszínre hozniuk a korábbi eseteket, és ez egy jó dolog. Képzeljük el, ha a mesterséges intelligencia képes lenne megbízhatóan létrehozni egy meggyőző jogi beadványt, és teljes pontossággal hajtana végre mindent. Az ügyvédek ezeket anélkül nyújtanák be, hogy megnéznék őket, biztosak lennének abban, hogy relevánsak. Ezek után a bírókon múlik majd, hogy mérlegeljék, hogyan alkalmazhatók ezek az esetek. Természetesen a mesterséges intelligenciához fognak fordulni, hogy összefoglalják a tényállást, és talán még a végső véleményük megfogalmazásához is mesterséges intelligenciát használnak majd. Végül az egész ítélkezési gyakorlatunkat az MI által indított és elbírált érvek fogják meghatározni. Az emberek csak nézők lesznek, a jogi szakembereknek pedig nagyon kevés munkájuk lesz.

Ugyanez vonatkozik más, pontosságot igénylő területekre is, ami nagyjából minden emberi szakmát jelent. Mivel nem bízhatunk az LLM-ekben, a hallucinációk egyfajta tűzfalat jelentenek köztünk és a tömeges munkanélküliség között. Eljön-e valaha az a nap, amikor megszabadulunk a hallucinációktól? A tudósok nem értenek egyet. "A válasz tág értelemben véve nem" - mondja Vempala, Ahmad viszont úgy gondolja, hogy megtehetjük. "A kutatóközösségben mostanában nagy figyelem irányul a hallucináció problémájára, és mindenféle szempontból foglalkoznak vele" - mondja.

Állandó táncot járunk a gépekkel, egyre inkább függő ölelésbe zárva. És mégis, mivel a robotok viselkedése nem emberi gondolkodási folyamatokon alapul, gyakran tehetetlenek vagyunk, hogy megmagyarázzuk tetteiket. A Stephen Wolfram által létrehozott Wolfram Alpha weboldal számos matematikai problémát képes megoldani. Úgy tűnik, azt is megjeleníti, hogy ezek a válaszok hogyan jönnek létre. Az emberek által látott logikai lépések azonban teljesen eltérnek a weboldal tényleges számításaitól. "Nem végez semmilyen érvelést" - mondja Wolfram. "Azok a lépések tiszta hamisítványok. De hogyan magyarázzuk el ezt egy embernek?"

A számítógépeknek néha csalniuk kell, különben kényelmetlenséget okoznak. Eric Horvitz - ma a Microsoft egyik vezető kutatója - az 1980-as években segített egy mesterséges intelligencia rendszert létrehozni, amely a patológusokat segítette a vizsgálatokban. Minden egyes eredményt elemzett, és javaslatot tett a következő vizsgálat elvégzésére. Egyetlen probléma volt csak - túl gyorsan adta meg a válaszokat. "Úgy találtuk, hogy az emberek jobban bíztak benne, ha egy villogó fénnyel ellátott késleltetési hurkot adtunk hozzá, mintha a rendszer a gombnyomás után azonnal előállt volna a válasszal" - mondja Horvitz.

De meg kell tanulnunk alkalmazkodni. A mesterséges intelligencia olyannyira létfontosságú egyes rendszerek - például a pénzügyi infrastruktúra - számára, hogy megszabadulni tőle sokkal nehezebb lenne, mint leválasztani a HAL 9000 moduljait. "Bizonyos értelemben azt mondhatjuk, hogy a sci-fi forgatókönyvek már most kezdenek megvalósulni" - mondja Hillis, a Thinking Machines munkatársa. "A számítógépek irányítanak, mi pedig az ő világukban élünk". Wolfram szerint ez a rejtély fokozódni fog, ahogy a mesterséges intelligencia új feladatokat vesz át, és egyre inkább kikerül az emberi felfogóképesség köréből. "Szabályozzuk-e a mögöttes algoritmust?" - kérdezi. "Ez őrültség, mert a legtöbb esetben nem lehet előre látni, hogy egy algoritmusnak milyen következményei lesznek."